Storage

Modificar LVM durante la instalación

Installing Proxmox VE filesystem ext4 o xfs

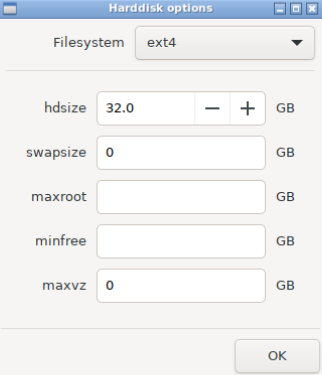

Durante la instalación, si se usa ext4 or xfs, el instalador por defecto crea un "Volume Group (VG)" llamado "pve", y "Logical Volumes (LVs)" adicionales llamados "root", "data", y "swap" . Para controlar el tamaño de esos volúmenes usa:

- hdsize

-

Define el tamaño total de disco usado.

swapsize

-

Define el tamaño de volumen "swap". Por defecto es el tamaño de la memoria instalada, mínimo 4 GB y máximo 8 GB. The resulting value cannot be greater than hdsize/8.

Si se configura 0, no se creará volumen de swap

maxroot -

Define the maximum size of the root volume, which stores the operation system. The maximum limit of the root volume size is hdsize/4.

- maxvz

-

Define el tamaño máximo del volumen "data".

Si se configura 0, no se creará el volumen "data".

- minfree

-

Define la cantidad de espacio libre que quedará en el "volume group pve".

En la imagen durante la instalación, en las opciones avanzadas de almacenamiento podemos eliminar los volúmenes "swap" y/o "data"

Si durante la instalación hemos eliminado los volúmenes "swap" y/o "data" podemos extender el volumen "root" para que ocupe todo el espacio:

lvextend -l +100%FREE /dev/pve/root resize2fs /dev/pve/root # para filesystem ext4 xfs_growfs /dev/pve/root # para filesystem XFSModificar LVM después de la instalación

Comandos para ver la configuración:

pvs # Display information about physical volumes vgs # Display information about volume groups lvs # Display information about logical volumespvdisplay # Display various attributes of physical volume(s) vgdisplay # Display volume group information lvdisplay # Display information about a logical volumeDeshabilitar "SWAP" en un nodo Proxmox

swapoff -aPara que el cambio sea persistente, elimina/comenta la línea swap en el fichero

/etc/fstab.... #/dev/pve/swap none swap sw 0 0 ...Eliminar volúmenes de LVM

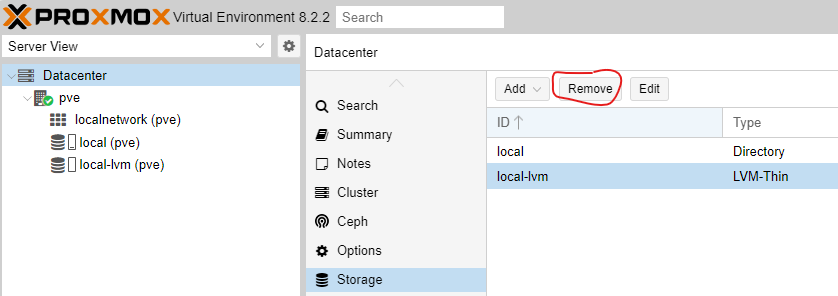

Si una vez instalado Proxmox queremos eliminar los volúmenes "swap" y "data", primero eliminaremos desde GUI el "Storage" "local-lvm"

lvs

LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert

data pve twi-a-tz-- <42.25g 0.00 1.59

root pve -wi-ao---- 34.87g

swap pve -wi-ao---- 8.00glvremove /dev/pve/swap

lvremove /dev/pve/dataPor último, extiende el volumen y el "filesystem"

lvextend -l +100%FREE /dev/pve/root

resize2fs /dev/pve/root # para filesystem ext4

xfs_growfs /dev/pve/root # para filesystem XFSiSCSI Multipah

Modifica la línea del fichero /etc/iscsi/iscsid.conf para que el valor por defecto de timeout de 120 sea 15

node.session.timeo.replacement_timeout = 15

Instalar las herramientas "multipath-tools"

apt update

apt install multipath-toolsComprobar los 'wwid' de los discos (World Wide Identification)

root@pve01:~# /lib/udev/scsi_id -g -u -d /dev/sdb

35000039b38715831

root@pve01:~# /lib/udev/scsi_id -g -u -d /dev/sdc

35000039b38715c41Crear el fichero de configuración '/etc/multipath.conf' con el contenido de los wwid:

blacklist {

wwid .*

}

blacklist_exceptions {

wwid "35000039b38715831"

wwid "35000039b38715c41"

}

defaults {

polling_interval 2

path_selector "round-robin 0"

path_grouping_policy multibus

uid_attribute ID_SERIAL

rr_min_io 100

failback immediate

no_path_retry queue

user_friendly_names yes

}Los "wwids" se deben añadir además al fichero '/etc/multipath/wwids'

multipath -a 35000039b38715831

multipath -a 35000039b38715c41Reiniciar el servicio multipathd

service multipathd restartComprueba

multipath -ll

mpathb (35000039b38715831) dm-6 HPE,MSA 2050 SAS

size=9.1T features='2 queue_if_no_path retain_attached_hw_handler' hwhandler='0' wp=rw

`-+- policy='round-robin 0' prio=30 status=active

|- 7:3:1:2 sdb 8:16 active ready running

`- 7:3:2:2 sdd 8:48 active ready running

mpatha (35000039b38715c41) dm-5 HPE,MSA 2050 SAS

size=3.3T features='2 queue_if_no_path retain_attached_hw_handler' hwhandler='0' wp=rw

`-+- policy='round-robin 0' prio=30 status=active

|- 7:3:1:1 sda 8:0 active ready running

`- 7:3:2:1 sdc 8:32 active ready runningpara obtener más información de los dispositivos:

multipath -v3Los dispositivos mutipath se pueden ver en /etc/mapper

ls -lah /dev/mapper/mpath*Cuando usamos multipath ya no podemos crear los volúmenes ZFS a traves de GUI

Crear un nuevo pool (rpool) con RAIDZ-1

Minimo 3 discos

zpool create -f -o ashift=12 rpool raidz1 /dev/mapper/mpatha /dev/mapper/mpathb /dev/mapper/mpathc